-

PLUS

8 smarta tips för Google Foto – Ta kontroll över bilderna i påsk

-

PLUS

Krönika: Nej AI, jag vill inte vara din kompis eller partner

-

PLUS

Kommentar: Hindren som stoppar Tre

-

PLUS

Tips: 8 knep till Googles anteckningsapp Keep

-

PLUS

Apple Intelligence påminner mig om något betydligt bättre

-

PLUS

Mobils stora guide till Apple Intelligence i Iphone

-

PLUS

Krönika: Mobiltillverkare för första gången, igen

-

PLUS

11 tips: Google-appen som kan mycket mer än du tror

-

PLUS

Krönika: Google är bra på gratis men usla på att ta betalt

-

PLUS

Så kan Xiaomi-telefonen bli Mac-datorns och Iphones bästa vän

Vad krävs för att bilderna ska bli bra?

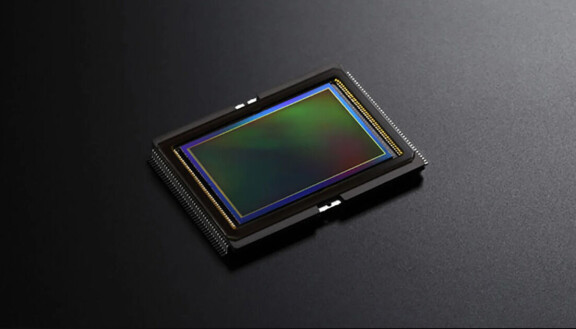

Mobil förklarar: Så funkar mobilens kamerasensor

Sensorn, mobilkamerans hjärta, är en avgörande faktor som avgör hur bra bilder en mobiltelefon kan fånga. Men vad är det som gör att en sensor är bra på att fånga bilder? Vi dyker ner i sensorernas värld för att försöka förklara vad som krävs för att bilderna ska bli bra.

När olika tillverkare lanserar sina nya mobiltelefoner pratas det ofta om kamerorna, och när det pratas om kamerorna pratas det gärna om sensorerna. Med rätta, för sensorn är den hårdvara som faktiskt skapar bilden, eller åtminstone samlar in ljuset som i sin tur skapar bilden. Hur detta görs påverkar alltså kamerans grundläggande förutsättningar för att generera så bra bilder som möjligt. Tanken i den här artikeln är att gå igenom ett par saker kring kamerasensorer för att få en bättre förståelse för vad som påverkar sensorns förmåga att fånga så bra bilder som möjligt. Vi kommer att ta upp saker som storlek, färgfilter och olika typer av sensorer.

Storleken har betydelse

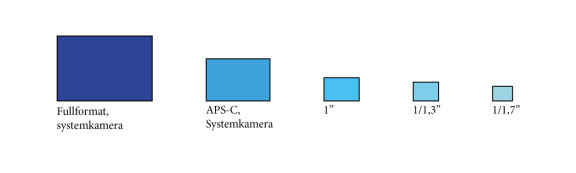

Mobiltillverkare har länge tävlat och jagat varandra när det gäller prestandan i sina telefoner. Vad gäller kamerorna i dessa har man gjort det på olika sätt. Till en början handlade det mycket om att öka upplösningen så mycket det gick, sen började man öka storleken på sensorn. Egentligen kan man väl säga att båda dessa “tävlingar” fortfarande pågår men på olika sätt hos olika tillverkare. Till exempel Samsung har ju satsat hårt på rejäl upplösning i form av en sensor på 200 megapixlar i sin Galaxy S23 Ultra, medan andra, som Sony och Xiaomi, satsar hårt på stora sensorer.

Storleken på sensorn har betydelse för hur bra sensorn är på att samla in ljus. Eller snarare på hur snabbt den kan samla in så mycket ljus som möjligt. När sensorn träffas av mer ljus blir signalen från den pixeln starkare vilket i sin tur ger mindre brus. En större sensor kommer att träffas av mer ljus än en mindre sensor, så länge bländaren är proportionerlig i storlek. Det är inte så konstigt. Är sensorn mindre måste den kompensera med att ta emot ljuset under en längre tid, öka sin känslighet eller ha en större bländare. Det första alternativet innebär att det är större risk för att motivet, eller du, rör dig medan bilden tas, vilket i sin tur leder till en suddig bild. Ökar du känsligheten, det vill säga att du förstärker den elektroniska signalen från sensorn, så kommer du också att förstärka bruset och bildkvaliteten blir sämre från den mindre sensorn. En större bländare är också möjligt, men leder ofta till andra optiska svårigheter som sämre skärpa och olika färgskiftningar i motiv med hög kontrast. Det bästa sättet att förbättra bildkvaliteten är alltså att öka storleken på sensorn, i alla fall när det kommer till att generera brus. Men det är ju inte bara att slänga in större sensorer, en större sensor tar mer plats och då måste tillverkaren antingen välja bort andra delar eller göra en större kameraklump vilket inte alltid är önskvärt.

Sensorstorleken är en av flera anledningar till att bildkvaliteten är så mycket bättre i en systemkamera än i en mobilkamera. De fångar helt enkelt in mer ljus.

Upplösning - hur många pixlar har du

Som nämndes ovan pågår det fortfarande lite av ett pixelkrig mellan olika tillverkare, eller snarare är det kanske så att olika tillverkare har valt att anta olika strategier. Vissa satsar på väldigt hög upplösning (många pixlar) medan vissa satsar på att ha en så stor sensor som möjligt. Liksom att en stor sensor ger bättre bilder så kommer en högre upplösning oftast också att resultera i bättre bilder, eller åtminstone möjligheten till bättre bilder. Bilderna blir också bättre på olika sätt. Det första och kanske mest självklara sättet är att en sensor med högre upplösning kan generera bilder med mer detaljer. Varje detalj i bilden återges med flera pixlar om sensorn har högre upplösning jämfört med om sensorn har lägre upplösning.

I vissa fall får man lägre brus när man har högre upplösning. Tittar man på en högupplöst bild och en lågupplöst bild i samma storlek så kommer den högupplösta bilden ha mindre brus och mer detaljer. Detta eftersom den inte behöver förstoras lika mycket som den lågupplösta bilden. När den lågupplösta bilden förstoras, förstoras även bruset. Det här är dock sällan ett problem om man bara tittar på bilder på mobilens skärm. Men om man till exempel skriver ut bilder, eller vill beskära dem för att du inte hade tillräckligt mycket zoom, så kommer det här att märkas. Det finns så klart fördelar med större pixlar, eftersom de fångar in mer ljus per pixel blir det dynamiska omfånget bättre. Det vill säga antalet nyanser den kan fånga upp mellan helt svart och helt vitt. Därför använder i stort sett alla tillverkare en teknik som kallas för pixelbinning.

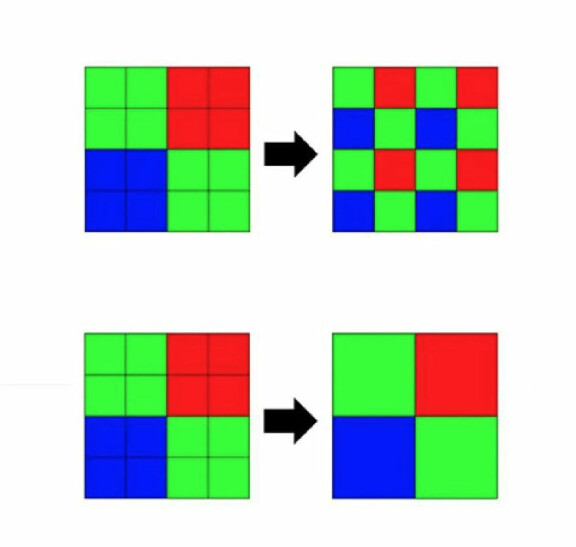

Pixelbinning - flera blir en

De allra flesta mobilkameror, oboeroende av hur högupplösta sensorer de har, genererar inte bilder som har sensorns hela upplösning. Utan de flesta spottar ur sig en bild som har en upplösning kring tolv megapixlar. Det här beror alltså på pixelbinning. Det innebär att sensorn slår ihop flera pixlar och använder dem som en enda pixel. Oftast slår man, med mjukvara, ihop fyra eller nio pixlar till en större pixel (i Samsung S23 Ultras fall slår man ihop 16 pixlar). Den skapade större pixeln levererar då ett medelvärde av det ljus de fyra fysiska pixlarna den består av tagit emot. Det ger en starkare signal, mindre brus och mer ljus per pixel. Man byter då alltså bort upplösning mot bättre färger och bättre dynamiskt omfång. Testar man att fotografera med kamerans högsta upplösning brukar man märka att det blir mer utfrätta ljusa partier och fler helt svarta partier, men i jämna ljusförhållanden får man bilder med bättre detaljrikedom. Vissa mobilkameror låter inte ens användaren välja att fotografera med hela sensorns upplösning, antagligen för att resultatet inte är direkt önskvärt.

Men då kanske du undrar “Men varför väljer då tillverkarna att öka upplösningen hela tiden? Om det nu är bättre med färre och större pixlar om de ändå inte använder hela upplösningen?” Det finns så klart fördelar med att ha en högupplöst sensor. Till exempel blir den digitala zoomen mycket bättre när det finns fler pixlar att zooma in i. Upplösningen i den inzoomade bilden bibehålls bättre om sensorn har en högre upplösning. Även möjligheterna att filma i till exempel 8K kommer tillsammans med den högre upplösningen.

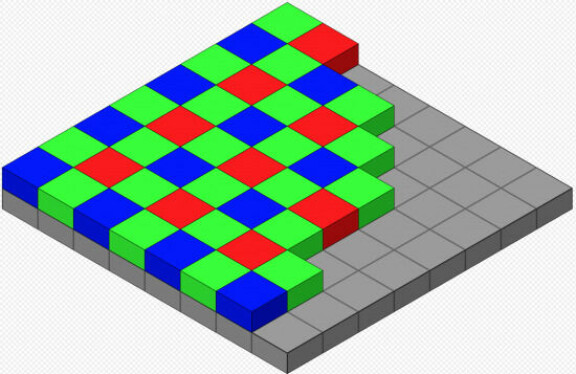

Filtren som ger dig färger

Förutom upplösning och storlek, påverkas bilden av vilken typ av sensor det är. Här finns det lite olika varianter, även om de flesta kör på samma typ av sensor. När det gäller olika typer av sensorer så finns det olika saker som skiljer, de två främsta är hur den är konstruerad samt vilken typ av färgfilter sensorn använder. En pixel i sig tar bara emot vitt ljus (det vill säga alla färger) och gör man inget mer med den så kommer bilderna att bli svartvita. Fint ibland visserligen, men de flesta vill även kunna ta bilder med färger. För att det ska fungera behöver man sätta ett färgfilter framför pixeln för att därmed isolera vilken typ av ljus sensorn tar emot.

Oftast använder man sig av ett så kallat RGB-filter i Bayerfiguration, vilket betyder röd-grön-blå, oftast fördelar man dessa med 25% röd, 25% blå och 50% grön eftersom det mänskliga ögat har högre känslighet för gröna färger.

Det finns dock tillverkare som har använt sig av andra metoder och färgfilter för att få fördelar. Bland annat har man utvecklat ett färgfilter som kallas CYYM, som då består av cyan, gul och magenta. Målet med det filtret var att det skulle släppa igenom mer ljus, vilket det också gjorde. Nackdelen som följde med på köpet innebar att det var svårare att genomföra den efterföljande konverteringen så att det blir korrekta färger i bilden. Därför blev det filtret inte så populärt. Däremot har Huawei använt sig av ett färgfilter som kallas RYYB, där man alltså bytt ut det gröna färgfiltret mot gult (Y=yellow). Det ska släppa igenom mer ljus och därmed resultera i en sensor som ger bättre bilder i svagt ljus. Färgfiltret användes på sensorn bland annat i P40 Pro vilken också var bra på att ta bilder i svagt ljus visade det sig i vårt mobilkameratet där den var med. Men om det beror på just det färgfiltret, eller något annat, är svårt att säga. Idag finns det telefoner som är bättre i mörkret och det beror delvis på så kallad computational photography, vilket innebär till exempel att kameran tar flera bilder med flera olika exponeringar och sedan lägger samman dem för att få fram täckning i hela bilden. Exempelvis är Google med sina Pixel-telefoner duktiga på det här.

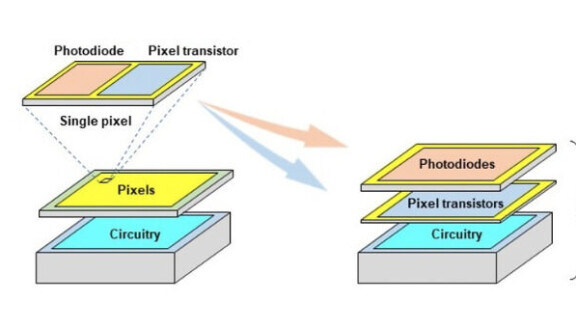

Lager på lager

En annan del av konstruktionen av sensorn som påverkar bildkvaliteten är hur sensorns lager är staplade. Sonys nyligen lanserade Xperia 1 V har en så kallad stackad sensor, vilket också ska vara den första mobiltelefonen med en sådan sensor. Det man menar med en stackad sensor i det här fallet, är att istället för att pixlarnas transistorer ligger i samma lager som pixeln så separerar man dessa i två lager vilket innebär att när transistorerna inte längre behöver trängas med pixlarna så kan deras storlek ökas. Det innebär att man får ner bruset och får ett ökat dynamiskt omfång i bilderna. En annan fördel är också att sensorn får en snabbare utläsning, vilket i sin tur leder till minskad så kallad rolling shutter. Rolling shutter är när du filmar eller fotograferar något som rör sig i sidled, eller när du själv rör kameran i sidled och raka streck blir sneda i filmer/på bilden. Det beror på att under tiden som sensorn läser ut bilden hinner du flytta kameran, vilket gör just att raka linjer upplevs som sneda. Med en snabbare utläsning minskar det här problemet. Ännu så länge är det dock bara Sony som använder den här tekniken i mobilkameror, men bland systemkameror är den vanligare, om än inte jättevanlig.

Bilder är mer än en sensor

Hur kan man då koka samman det vi har gått igenom? Jo, att en större sensor oftast är bra eftersom det ger mer ljus och därmed mindre brus. En större sensor kan också skapa ett större djup i bilden utan att använda sig av mjukvara för att skapa oskärpa. Men att stoppa in en större sensor innebär att kameradelen tar mer utrymme i telefonen, vilket blir en designmässig utmaning för tillverkarna. En högre upplösning är, om den används rätt, också en bra egenskap eftersom det då finns fler pixlar att använda för till exempel digital zoom. Men det ger också fler detaljer i bilderna och möjlighet till mindre brus. Ser man till sensorernas uppbyggdnad så använder det flesta sig av ett vanligt så kallat bayermönster när det gäller färgfilter, det har funnits tillverkare som försökt med annat. Men de är ett fåtal. Däremot ser vi fortfarande en spännande utveckling av hur sensorer är konstruerade, vilket bland annat leder till snabbare utläsning och bättre dynamisk omfång.

Ska man försöka sammanfatta utvecklingen hittills på ett kortfattat sätt kan man väl säga att sensorerna har blivit bättre genom att de blivit större och fått högre upplösning. Tillverkarna har också blivit bättre på att utnyttja de pixlar de har till förfogande. Något som sker med hjälp av mjukvarutekniker som pixelbinning och computational photography. Men också tekniska utvecklingar som Sonys nya stackade sensor.

Trots allt detta harvande om hur en sensorn är uppbyggd och vilka egenskaper hos sensorn som ger en bra bild, går det inte att säga att det bara är sensorn som är avgörande. En bil blir inte fantastiskt bara för att du sätter i en rejäl motor, är det punktering på tre av däcken kommer det inte att fungera ändå. Förutom sensorn behövs skarpa linser i objektiven men också bra mjukvara. Idag används mjukvara i stor utsträckning för att ta fram slutresultatet, bilden. För att ta fram en bra sådan krävs alltså inte bara bra hårdvara, där sensorn är en del, utan också bra mjukvara som hanterar den data hårdvaran genererar. Som vanligt är det ett samspel där alla delar måste göra sitt, för att helheten ska bli bra.