-

PLUS

8 smarta tips för Google Foto – Ta kontroll över bilderna i påsk

-

PLUS

Krönika: Nej AI, jag vill inte vara din kompis eller partner

-

PLUS

Kommentar: Hindren som stoppar Tre

-

PLUS

Tips: 8 knep till Googles anteckningsapp Keep

-

PLUS

Apple Intelligence påminner mig om något betydligt bättre

-

PLUS

Mobils stora guide till Apple Intelligence i Iphone

-

PLUS

Krönika: Mobiltillverkare för första gången, igen

-

PLUS

11 tips: Google-appen som kan mycket mer än du tror

-

PLUS

Krönika: Google är bra på gratis men usla på att ta betalt

-

PLUS

Så kan Xiaomi-telefonen bli Mac-datorns och Iphones bästa vän

Google IO

Vi sammanfattar det viktigaste från Google IO 2024

Här kan du se det viktigaste från Googles inledningsanförande på utvecklarkonferensen Google IO 2024.

Det var tydligt AI-fokus på Googles utvecklarkonferens, precis som väntat, men vi fick inte se något av kommande telefoner eller annan hårdvara, inte ens en smygtitt på kommande prylar. Inte heller nämndes ett ord om Wear OS.

Istället var det stort fokus på de som faktiskt konferensen riktas till, mjukvaruutvecklare, och hur de kan använda AI för att skapa nya tjänster och användarupplevelser. Vi fick också se många exempel på hur AI tar plats i Googles tjänster som Gmail, Google Foto, Maps och Sök.

I Sök ger AI översikter så att du kan ställa komplexa frågor i flera steg och på det sättet låta Google ge dig snyggt uppspaltade svar. Sök baseras fortfarande på Googles fundament med värdering av vilka källor som är betrodda, men sökupplevelsen laddas med AI och ska kunna planera, sammanfatta, jämföra och utvärdera åt dig.

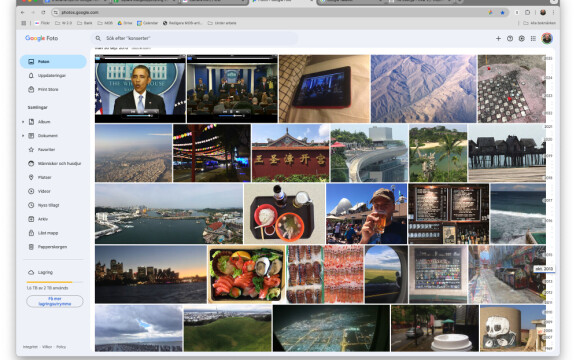

I Google Foto ska du kunna fråga avancerade frågor baserat på de bilder du har lagrat där. Till exempel "vad är registreringsnumret på min bil" eller "när lärde sig min dotter simma" och så ska Google kunna svara på det, baserat på de bilder du har.

I Gmail kommer AI kunna sammanfatta långa mailtrådar och ge svar på frågor baserat på sökningar i allt från bilagor till separata konversationer.

En sak som google betonade gång på gång var att deras AI-motor Gemini är multimodal från grunden. Det innebär att den egentligen är neutral inför vilken form informationen in och ut har. Det ger många fördelar. Googles Gemini kan översätta bilder till text men också sammanställa information som finns i både bild, text och ljud. Ett exempel på det är att du i olika Google-funktioner kommer att kunna göra sökningar genom att spela in en video där du till exempel visar en pryl som inte fungerar och frågar vad det kan bero på.

Men också åt andra hållet. Google gav ett exempel på hur man matar in kurslitteratur i motorn och ber den presentera informationen muntligt för folk som lär sig lättare på det viset. I exemplet lästes inte informationen upp, utan den levererades som en dialog mellan två personer, och du kunde dessutom bryta in med frågor som de då tog upp och svarade på.

Google lade även upp riktningen för Android 15 där AI står i centrum och det läser du mer om här i vår separata nyhet om det.