-

PLUS

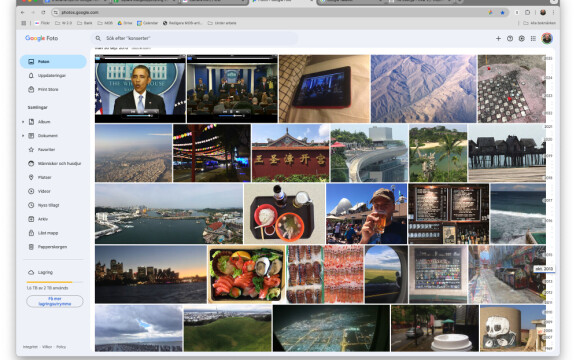

8 smarta tips för Google Foto – Ta kontroll över bilderna i påsk

-

PLUS

Krönika: Nej AI, jag vill inte vara din kompis eller partner

-

PLUS

Kommentar: Hindren som stoppar Tre

-

PLUS

Tips: 8 knep till Googles anteckningsapp Keep

-

PLUS

Apple Intelligence påminner mig om något betydligt bättre

-

PLUS

Mobils stora guide till Apple Intelligence i Iphone

-

PLUS

Krönika: Mobiltillverkare för första gången, igen

-

PLUS

11 tips: Google-appen som kan mycket mer än du tror

-

PLUS

Krönika: Google är bra på gratis men usla på att ta betalt

-

PLUS

Så kan Xiaomi-telefonen bli Mac-datorns och Iphones bästa vän

GPT-4o i antågande

OpenAI presenterar ny språkmodell

Den nya språkmodellen ska bland annat kunna tolka ljud, bilder och text i realtid.

OpenAI har presenterat GPT-4o, sin mest avancerade språkmodell hittills, som har förmågan att tolka och bearbeta ljud, bild och text i realtid. Namntillägget med bokstaven “o” i GPT-4o representerar “omni”.

Den nya språkmodellen ska göra det enklare att föra samtal med AI:n tack vare en extremt förbättrad svarstid. Utvecklarna påstår att GPT-4o kan reagera på ljud på endast 232 millisekunder, med ett genomsnitt på 320 millisekunder, vilket ska vara jämförbart med mänsklig reaktionstid under samtal. Den här förbättrade responsförmåga möjliggör mer flytande och naturliga röstsamtal med ChatGPT. GPT-4o matchar GPT-4 Turbos prestanda för engelska och programkod, och överträffar dess förmåga för andra språk.

GPT-4o ska också vara överlägsen tidigare modeller när det gäller att förstå och tolka visuella data. OpenAI meddelar att modellen inte bara kan hantera kombinationer av text, ljud och bild som indata, utan även kunna skapa sådana kombinationer som utdata. OpenAI konstaterar att “Eftersom GPT-4o är vår första modell som kombinerar alla dessa modaliteter har vi fortfarande bara skrapat på ytan när det gäller att utforska vad modellen kan göra och dess begränsningar.”

OpenAI har påbörjat en gradvis utrullning av GPT-4o i ChatGPT. Den nya språkmodellen kommer att vara tillgänglig för alla användare utan kostnad. De förbättrade och snabbare röstsamtalen är fortfarande under utveckling och kommer att alfa-testas av betalande kunder under de närmaste veckorna.