-

PLUS

8 smarta tips för Google Foto – Ta kontroll över bilderna i påsk

-

PLUS

Krönika: Nej AI, jag vill inte vara din kompis eller partner

-

PLUS

Kommentar: Hindren som stoppar Tre

-

PLUS

Tips: 8 knep till Googles anteckningsapp Keep

-

PLUS

Apple Intelligence påminner mig om något betydligt bättre

-

PLUS

Mobils stora guide till Apple Intelligence i Iphone

-

PLUS

Krönika: Mobiltillverkare för första gången, igen

-

PLUS

11 tips: Google-appen som kan mycket mer än du tror

-

PLUS

Krönika: Google är bra på gratis men usla på att ta betalt

-

PLUS

Så kan Xiaomi-telefonen bli Mac-datorns och Iphones bästa vän

Barnsäkerhet bortplockad

Apple lägger ner planerna på fotogranskning av Icloud-bilder

Apple skrinlägger planerna på fotogranskning för att hitta och varna om nakenbilder eller andra känsliga motiv.

I augusti i år tillkännagav Apple att de tänkte introducera en funktion för att hitta det som kallas för CSAM, en förkortning för Child Sexual Abuse Material. Funktionen gick ut på att användares iCloud-bibliotek automatiskt skulle genomsökas efter bilder som föreställer sexuella övergrepp mot barn.

Funktionen möttes av massiv kritik där kritikerna hävdade att Apple skulle kunna tvingas av stater och andra mäktiga intressenter att använda funktionen för att leta efter bilder med annat innehåll än CSAM.

I september meddelade Apple att man hade för avsikt att skjuta upp introduktionen av funktionen. Nu verkar det som att företaget har lagt ner planerna på att lansera den då all relaterad information har plockats bort från företagets hemsidor.

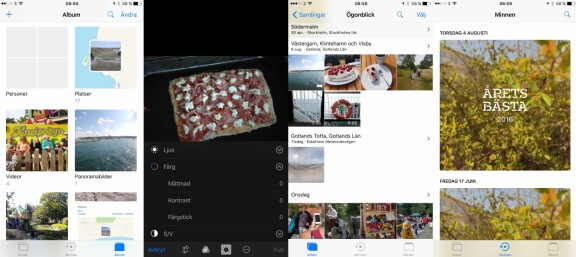

Apple har även lanserat uppdateringen till Ios 15.2 där man introducerar funktionen för ökad barnsäkerhet, men även här lyser CSAM-funktionen med sin frånvaro.