-

PLUS

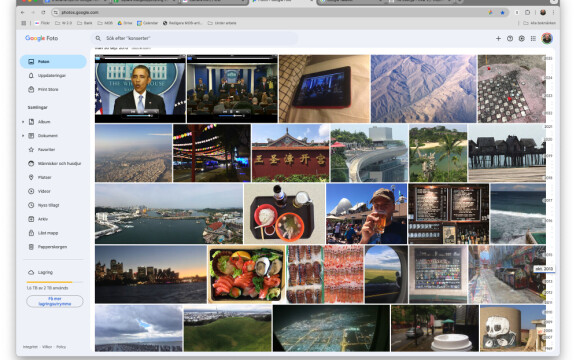

8 smarta tips för Google Foto – Ta kontroll över bilderna i påsk

-

PLUS

Krönika: Nej AI, jag vill inte vara din kompis eller partner

-

PLUS

Kommentar: Hindren som stoppar Tre

-

PLUS

Tips: 8 knep till Googles anteckningsapp Keep

-

PLUS

Apple Intelligence påminner mig om något betydligt bättre

-

PLUS

Mobils stora guide till Apple Intelligence i Iphone

-

PLUS

Krönika: Mobiltillverkare för första gången, igen

-

PLUS

11 tips: Google-appen som kan mycket mer än du tror

-

PLUS

Krönika: Google är bra på gratis men usla på att ta betalt

-

PLUS

Så kan Xiaomi-telefonen bli Mac-datorns och Iphones bästa vän

Information oavsett form

Krönika: Mobilen ännu mer i centrum i Googles AI-vision

Ett mer självsäkert Google presenterade AI-innovationer som kan förändra hur vi hanterar information.

Förra årets Google I/O hade ett Google på defensiven, som närmast desperat måste visa upp att de minsann också, inte bara OpenAI, var ledande inom artificiell intelligens. Det var en hel del interna utvecklingsprojekt som slängdes upp som kommande nyheter.

Till ytan var årets keynote på Google I/O snarlik, men det var ett betydligt mer självsäkert Google som återfått fotfästet. Det handlade fortfarande helt och hållet om AI, men man kunde unna sig att skämta om hur många gånger det nämndes i presentationen (över 120, ordet fortsatte nämnas efter att man räknat). Framför allt visste Google att vi denna gång skulle bli imponerade över deras exempel, som i många fall låg nära färdiga produkter.

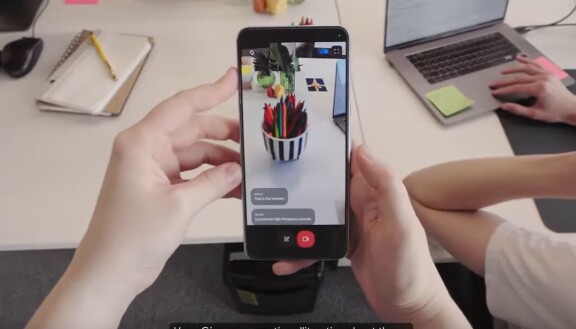

Jag kunde återge ett par av de mer imponerande exemplen (Kolla in https://www.youtube.com/watch?v=nXVvvRhiGjI&t=12s&ab_channel=Google) men de gör sig inte nödvändigtvis bra i text. Vilket var poängen. När Google presenterade AI-motorn Gemini 1.5 Pro så nämnde man återkommande att den var designad från grunden för att vara multimodal. Det innebär att den kan ta till sig information i textform, bildform, som ljud eller video, och också producera information i dessa olika former. I exemplen rörde sig den artificiella intelligensen obehindrat mellan olika uttrycksformer och den översatte kurslitteratur till tal, inte bara uppläst utan som en dialog mellan två röster som diskuterade innehållet för de som lättare tar till sig information på det sättet. Du kunde även felsöka tekniska prylar genom att filma dem, visa vad som inte fungerade och berätta vad problemet var ( https://www.youtube.com/live/XEzRZ35urlk?si=h73nEaSzK6L0RKOR&t=3047).

Vad som knappt nämndes alls i Googles Keynote var mobiler eller Android. Tidskriften The Economist och flera andra argumenterar för att AI innebär döden för smartphonen och att vi kommer att interagera med AI med nya typer av prylar, till exempel AR-glasögon, men jag ser snarare motsatsen. Om du vill mata in information i blandad form beroende på vad som är smidigast för stunden behöver du en kamera som kan ta stillbilder och video, en ljudinspelare, en textterminal och en Internetuppkoppling och det är svårt att se att du kan få allt detta i ett bättre format än just mobilen. AI möjliggör alternativa kommunikationssätt, men när till och med Apple har svårt att väcka någon entusiasm för AR-headset tror jag att det spåret är dött. Google talade inte om mobiler, men de var konstant närvarande i Googles demonstrationer av nya funktioner.

Nu var ju det här teknikdemos, och alla som försökt använda AI i praktiken vet att det är hit or miss, ofta fantastiskt men inte sällan med direkta felaktigheter. Google har också ett sätt att presentera ett skapat användningsområde som om det bara var ett exempel på något som i själva verket är oändligt flexibelt. Men låt oss anta att Google kommer att få allt det här att fungera som aviserat framöver, och i mer generell form än bara att veta hur man lagar en skivspelare.

Det är då väldigt mycket arbete som vi utför idag som blir onödigt, samtidigt som annat arbete blir väldigt värdefullt. Min sambo är till exempel forskare. AI är värdelöst utan information in, och att samla data och analysera den är ju centralt i en forskares arbete. Sedan lägger man en massa tid på att paketera om den informationen i en vetenskaplig artikel som är hårt mallad och vore en baggis att producera automatiserat. I Googles framtidsvärld kan dessutom denna information automatiskt packas om som du önskar, som populärvetenskaplig artikel, en myndighetsbriefing eller varför inte en prata på Youtube?

Mycket av det vi journalister gör handlar ju också om att packa om information från ett format till ett annat, vilket alltså kan bli överflödigt. Det vi tillför som är desto viktigare är värderingar, åsikter och bedömningar, som i den här krönikan. Eller om du så vill skillnaden mellan journalistik och ren reklam eller propaganda.

Här ligger ett tungt ansvar på Google, för en av poängerna med att leta upp informationen själv istället för att få den färdigpackad och presenterad är att du ser vem avsändaren är och kan bedöma om den är trovärdig. Det jobbet faller då på Google, som när de packar om informationen både måste se till att källorna är trovärdiga och redovisa dem så att användaren själv kan kontrollera det.

Den artificiella intelligensen kan göra en hel del av vårt arbete onödigt men är samtidigt helt beroende av att vi gör ett bra arbete.